Apacheのアクセスログを分析することによって、クローラーがあなたのサイトで何を実行しているのかを知ることができます。しかもこれ、かなり簡単です。

アナリティクスやサーチコンソールによる運営状況の確認は、ほとんどのサイト運営者が行っているでしょう。しかしログファイルまで分析している方はなかなかいません。

ログを直接分析することによって、アナリティクスでは分からないデータが得られます。

つまり、競合サイトと差がつく分析が出来るということです。結果として、後発でも追い抜けるようなインサイトを得たり、施策を試すことが出来たりといった確率が上がります。

本稿ではそんなアクセスログについて、基礎的な知識から具体的な分析方法の紹介をします。

1.アクセスログとは

ApacheというWebサーバーソフトウェアのログ(記録)の一種です。サイトへのアクセスがある度に、その情報が記録されています。

ぶっちゃけアクセスログを分析するだけなら、Apache周りの知識はほぼ必要ありませんので、「誰がサイトに来たかが分かる記録」くらいの認識でOKです。

さて、そんなアクセスログには以下の情報が記載されています。

✅アクセスログで分かること

・アクセスしてきたデバイスのIPアドレス

・HTTPリクエストが行われた日付と時間

・要求されたURL。つまりどのページに訪れたのか

・ステータスコード。リダイレクトされたのか、など。

・直接アクセスしたのか、リンクを辿ったのか。

・ユーザーエージェント。クライアントのOS、ブラウザが分かる。

具体的には以下のような英語と数字の羅列として表示されます。

例:www.forexample.com 202.168.159.130 – – [06/Nov/2019:07:00:00 +0900] “GET /http://www.forexample.com/about/rep/ HTTP/2.0” 200 922 “-” “https://www.forexample.com” “Mozilla/5.0 (Windows NT 10.0; Win64; x64)

1日分のファイルでも、この文字列が数千行に及ぶことは当たり前です。アクセスが多いサイトであれば数万行に達することもあるでしょう。

これだけ聞くと大変そうだと感じる方もいらっしゃるでしょうが、実際はそうでもありません。

これらのデータを全て解析しなければならないわけではありませんし、ログファイルを投げるだけで分かりやすくグラフで分析してくれるツールがあります。次の章で紹介します。

2.分析

先ほどの例のように、ログはそのままでは文字の羅列でしかないため、かなり見にくかったですよね。そのため、ツールを使用して簡単に分析できるようにしましょう。

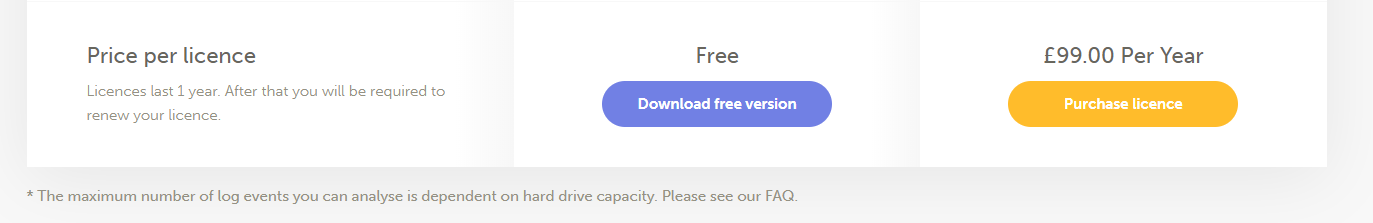

現在ログファイル分析ツールは沢山ありますが、本稿では「Screaming Frog Log File」を紹介します。無料版でも十分な機能を提供してくれるのでオススメです。

2-1.Screaming Frog Log Fileのインストール

Screaming Frog Log File公式サイト—https://www.screamingfrog.co.uk/log-file-analyser/

このURLからダウンロードします。ページを開いて下の方にスクロールすると、紫背景でDownload for freeと書かれたボタンがあるのでクリックします。

ダウンロードが終わったら、そのファイルを実行してインストールしましょう。これだけで終了です。

2-2.ログファイルのダウンロード

開発者の方であれば取得方法はご存知かと思われますので、本稿では有名なXサーバーでサイトを運営している方に向けて取得方法を記載します。

その他のレンタルサーバーを使用している方は、各サーバー会社のマニュアルページからご参照ください。

Xサーバーにおけるアクセスログ取得方法① 「サーバーパネル」にログインし、「アクセスログ」をクリック

② 取得したいドメインを選択し、ダウンロード

2-3.Screaming Frog Log Fileの使い方

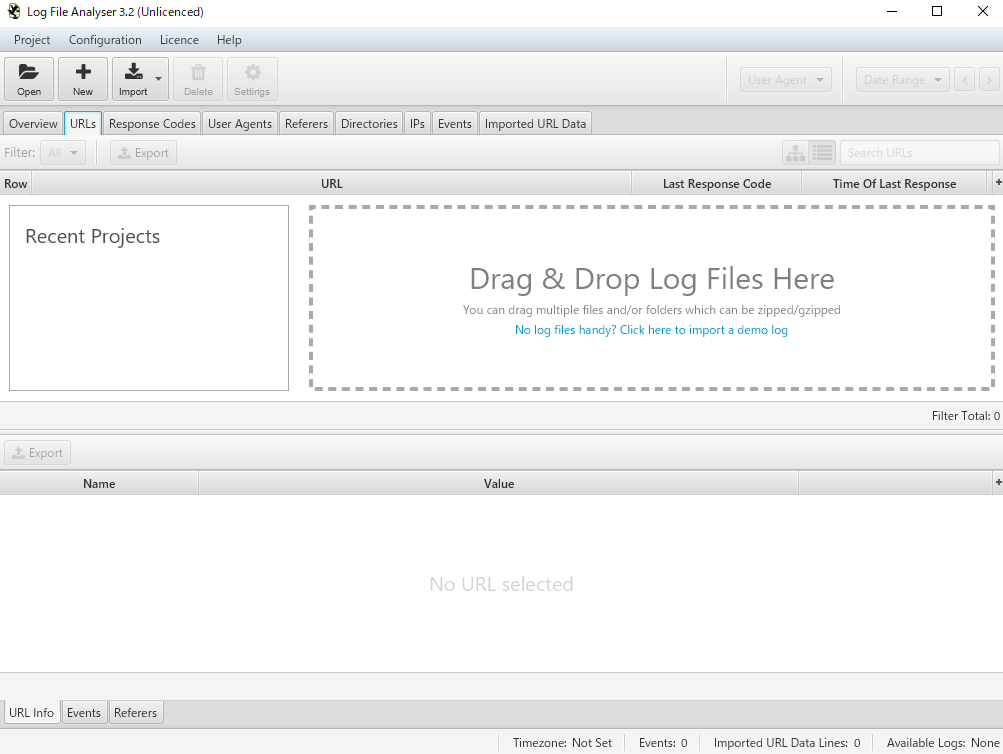

アプリを起動するとこの画面が出てきます。

Drag & Drop Log Files Hereと書かれている枠の中に、分析したいファイルをドラッグ&ドロップするだけでログファイルの中身を見やすく表示してくれます。

無料版の場合、一度に表示出来るのは1つのファイルだけです。2つ以上のファイルを分析したい方は、その都度データを削除してから別ファイルを投げる必要があります。

2-4.具体的な分析方法

・頻繁にクローラーがクロールするページの確認

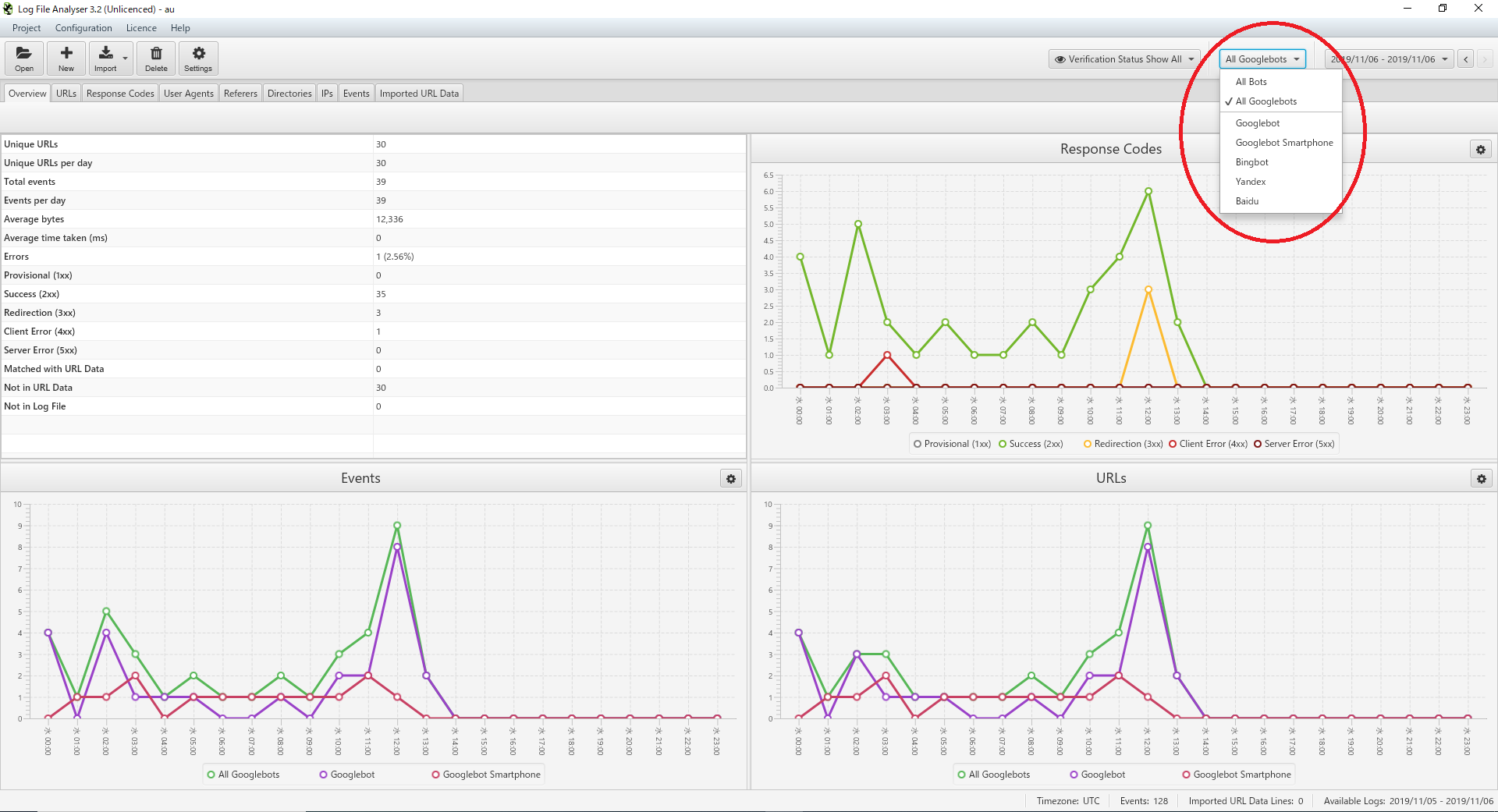

ツールにアクセスログのファイルを投げると、まずは概要ページが表示されます。基本的にはGooglebotだけを確認できれば良いので、右上の「All bots」を「All Googlebots」に変更します。

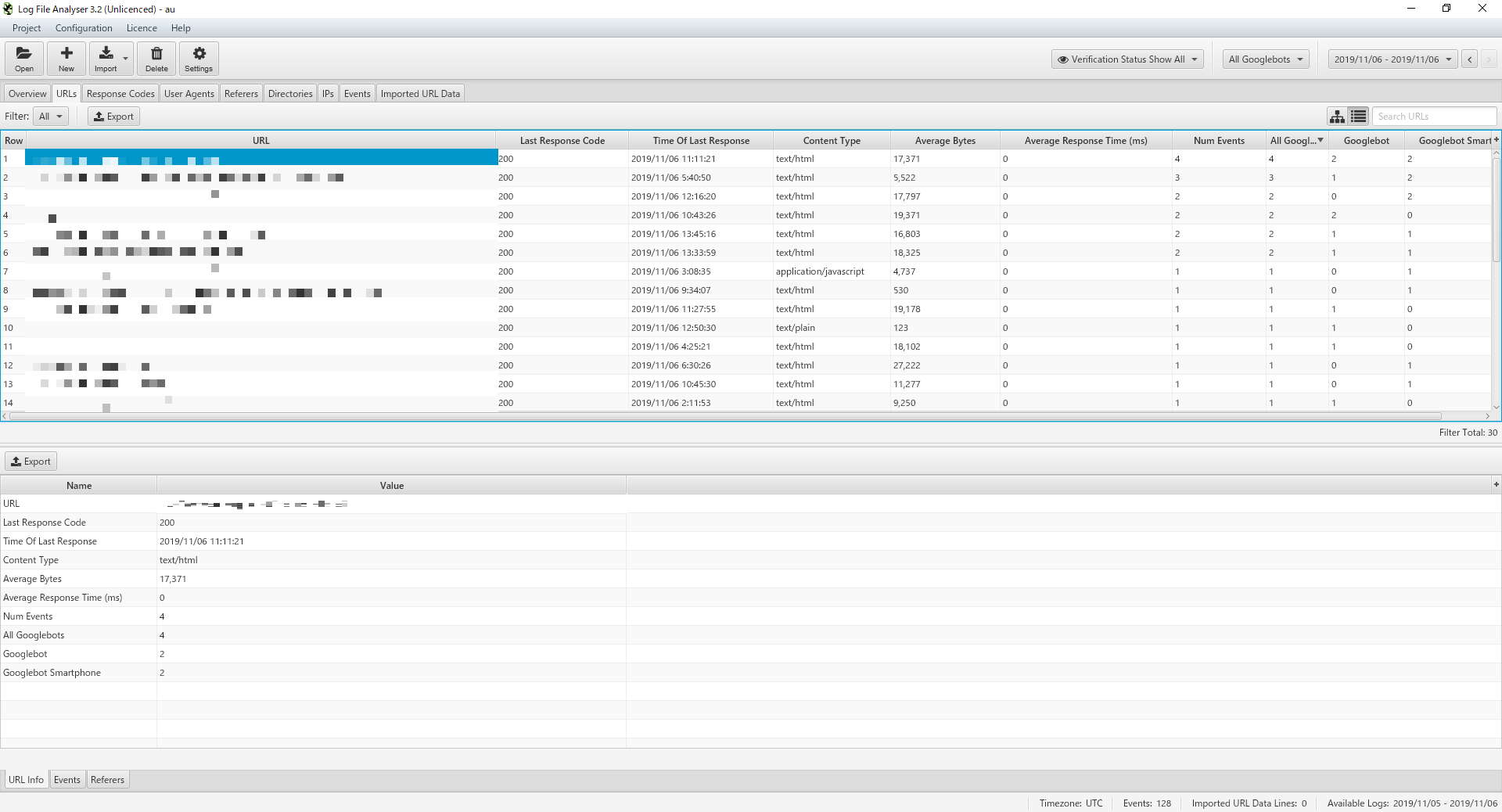

概要ページでは詳細まで知ることが出来ないので、URLページに移動します。

以下の項目を中心にチェックしていきます。

✅確認すべき項目

・クローラーが最も巡回しているページはどれか?

・巡回しているクローラーの種類は?

・クローラーは自分が意図したページを巡回できているか?

・ステータスコードで300~500番台が出てないか?

・スパムの確認

CHECK

最近はGooglebotになりすましてアクセスしているスパマーも多いので、hostコマンドを利用して本当にGooglebotが呼び出し元であるかどうかの確認をしましょう。

詳しくは公式が以下のページで発表していたので、こちらをご参照ください。

Googleウェブマスター向けブログ—https://support.google.com/webmasters/answer/80553?hl=ja

3.結果を元に、クロールを最適化

分析をしただけでは意味がありません。結果を元にサイトを改善しましょう。クローラーの巡回頻度と、クロールするページの数を増やす施策を行うことが基本指針です。

以下で分析・改善を行う際にヒントとなる項目を紹介します。参考までに。

・サーバーエラー:

500番台のエラーはサーバーに問題がある場合送信されるステータスコードです。一部のページで500番台のエラーが大量に起きている場合に注意してください。

・処理失敗:

400番台のエラーはクライアント側のエラーです。クローラーが400番台のエラーを検出している場合、何が問題なのかログを元に修正します。

・リダイレクト:

300番台のステータスコードはアドレスが移転したことの通知です。リダイレクト設定は意図したように行われているか、リダイレクト先がインデックスされているのかなど確認します。

・クローラーが見逃しているコンテンツの発見:

完全にスルーされているコンテンツがあれば、サイトマップ内の優先順位を変更するなど対策をしましょう。

・クロールの頻度とトラフィックを比較:

クローラーのクロール頻度とトラフィックを比較することで、高いトラフィックを得ているページ(クロール頻度を上げることが可能なページ)が明確になるはずです。

アクセスログを分析し、結果を元に修正を加えていくサイクルを何度も繰り返すと、確実にクロールに好影響を与えることが出来ます。

インデックス速度は、特にサイトを立ち上げたばかりの時に重要です。Googleから正しくコンテンツを評価してもらうためにも、内部対策をアクセスログ分析という武器を使いつつ攻略しましょう。